Desinformation wirksam bekämpfen

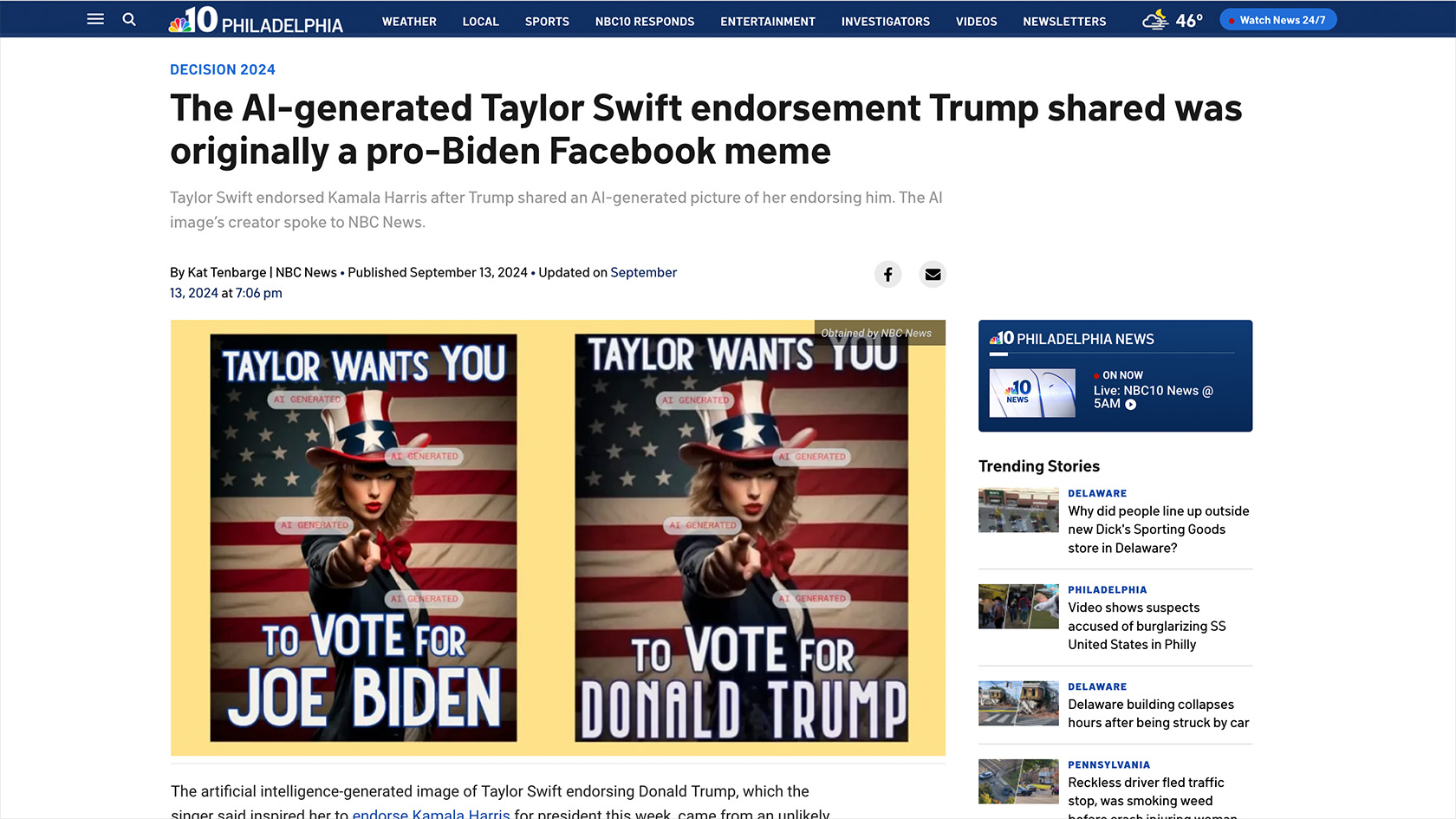

Das Meme machte im vergangenen Sommer weltweit Schlagzeilen: Taylor Swift fordert ihre Fans dazu auf, Donald Trump zu wählen. Der aufsehenerregende Fall verdeutlicht die zunehmende Furcht, dass Bild- oder Tondokumente mit Hilfe generativer künstlicher Intelligenz gefälscht werden und so etwa den Ausgang von Wahlen oder Abstimmungen beeinflussen können.

Die Diskussion darum, ob und wie mit KI erzeugte Inhalte deshalb gekennzeichnet werden sollen, vermischt jedoch oft zwei Dinge, die per se nichts miteinander zu tun haben, erklärt Fabrizio Gilardi, vom Institut für Politikwissenschaft IPZ an der UZH: «Was man verhindern möchte, ist die Verbreitung von falschen Inhalten, nicht aber die Verbreitung von Inhalten, die mit KI erzeugt wurden.»

Ob etwas wahr oder falsch ist, hat nichts mit der Art und Weise zu tun, wie der Inhalt produziert wurde.

KI-generiert bedeutet nicht automatisch gefälscht

Eine Kennzeichnung des Memes von Taylor Swift als «AI generated», wie dies einzelne Medien machten, schiesst deshalb am Ziel vorbei. Denn das Bild, das sich an das bekannte «Uncle-Sam-Wants-You»-Plakat aus der Zeit des ersten Weltkriegs anlehnt, war zwar mit Hilfe einer KI-Software erzeugt worden. Die eigentliche Fälschung bestand allerdings darin, dass auf dem Meme der Name von Joe Biden mit jenem von Donald Trump ausgetauscht worden war.

«Ob etwas wahr oder falsch ist, hat nichts mit der Art und Weise zu tun, wie der Inhalt produziert wurde,» betont Gilardi. Dennoch würden viele Menschen automatisch eine Verbindung zwischen KI-generiert und falsch herstellen. Die beiden Aspekte haben jedoch keinen inhärenten Zusammenhang und müssen voneinander getrennt werden, wenn es um Massnahmen und Regulierungen gehe, mit denen man die Verbreitung von gefälschten Inhalten eindämmen will.

Weniger Vertrauen in KI-generierte Inhalte

Zusammen mit Sacha Altay vom IPZ untersuchte Gilardi in einer kürzlichen publizierten Studie, welchen Einfluss eine Kennzeichnung von Schlagzeilen mit dem Hinweis «KI erzeugt» auf deren Wahrnehmung und Verbreitung hat. Proband:innen stuften dabei Inhalte, die mit einem Label wie «KI erzeugt» gekennzeichnet waren, als weniger vertrauenswürdig ein und waren weniger bereit, diese zu teilen.

«Dieser Effekt ist allerdings eher klein», erklärt Sacha Altay. Viel stärker – nämlich dreimal mehr – wirkte es, wenn die Schlagzeilen deutlich als «falsch» kennzeichnet waren. Wenn es also darum geht, Plattformen, wie Facebook, oder YouTube zu verpflichten, gefälschte Inhalte, die mit KI erzeugt sind zu kennzeichnen, ist die Art der Hinweise relevant: «Es ist wirksamer, solche Inhalte konkret als Fälschungen zu bezeichnen, als sie lediglich mit einem KI-Label zu versehen», erläutert Altay.

Unerwünschte Nebeneffekte

Labels wie «KI generiert» verhindern gemäss Gilardi und Altay deshalb nur beschränkt die Verbreitung von Falschinformationen. «Sie können sogar eine unerwünschte Wirkung haben», so Gilardi. Der Effekt, dass die Proband:innen den als KI-generiert gekennzeichneten Schlagzeilen misstrauen, war unabhängig davon, ob diese wahr oder falsch waren. Das heisst, entsprechende Labels können auch das Vertrauen in unproblematische mit KI erzeugte Inhalte schmälern.

Denn KI-Tools werden nicht nur eingesetzt, um Deepfakes zu produzieren. Viele Medienschaffende nutzen sie als Instrumente bei der täglichen Arbeit. Etwa, um Texte zu übersetzen, sie stilistisch anzupassen, kurze Zusammenfassungen zu schreiben oder Illustrationen zu erzeugen. Das macht die damit bearbeiteten Inhalte aber nicht falsch oder unwahr.

Wichtig sei deshalb, dass man nicht einfach generelle Labels wie «KI erzeugt» verwende, so Altay, sondern klar darlege, welchen Anteil KI an der Erstellung des Inhalts hatte. Denn das Misstrauen verliert sich, wenn erklärt wird, dass KI nur unterstützend eingesetzt wurde – zum Beispiel, um den Stil anzupassen.

Fruchtbarer Boden für Desinformation

Gilardi vermisst zudem in der Regulierungsdiskussion zur Vermeidung von Desinformation die Sicht auf die Rezipient:innen. «Viele Diskussionen und Lösungsansätze fokussieren auf die Produktion und die Verbreitung der Inhalte», sagt Gilardi. Was aber oft vernachlässigt werde, sei, dass es auch eine Nachfrage für diese Inhalte gebe. Gerade mit KI erzeugte Falschinformationen seien oft ziemlich primitiv gemacht und einfach als Fälschungen zu erkennen. «Trotzdem funktionieren sie, weil genügend Menschen daran glauben wollen.»

Das Misstrauen in Institutionen, den wachsenden Populismus oder den zunehmenden Rassismus könne man nicht mit der Regulierung von Online-Plattformen bekämpfen, ist auch Altay überzeugt. «Allein mit Faktenchecks lassen sich gesellschaftlichen Probleme kaum lösen.»

Es gibt sehr wenige Belege dafür, dass Desinformationskampagnen tatsächlich die Einstellung von Menschen ändern können.

Übertriebene Befürchtungen

Altay hält auch die Befürchtungen vor dem schädlichen Einfluss von generativen KI-Tools für übertrieben, wie er in einem Kommentar in der Fachzeitschrift «Misinformation Review» festgehalten hat. Einen Grund dafür, dass Desinformation in den Medien westlicher Demokratien relativ selten sei, sei die Arbeit von Journalist:innen und Expert:innen, die Fakten prüfen und klarstellen. «Die Medien in Westeuropa leisten gute Arbeit, keine Fake News zu verbreiten», so Altay. Deshalb hält er es im Kampf gegen Desinformation für essenziell, solche Institutionen zu stärken.

Die Forschung zeigt aber auch, dass der Einfluss von Desinformationskampagnen in der Regel überschätzt wird. «Es gibt sehr wenige Belege dafür, dass Desinformationskampagnen tatsächlich die Einstellung von Menschen ändern können», so Altay. Wenn solche Kampgagnen einen nachweislichen Effekt hätten, dann sei dieser sehr klein.

Regulierung zu Desinformation

Welche Massnahmen sind also sinnvoll, für die Regulierung von Online-Plattformen. Wie kann man Desinformation verhindern oder eindämmen? Mit diesen Fragen befasst sich das Strategy Lab der Digital Society Initiative der UZH dieses Jahr und leistet damit einen Beitrag zur Diskussion um eine Regulierung grosser Online-Plattformen in der Schweiz. Der Bundesrat hat im April beschlossen, eine entsprechende Vorlage zu erarbeiten und in die Vernehmlassung zu geben.

In einer Reihe von Veranstaltungen und Workshops widmet sich das Strategy Lab in den kommenden Wochen dem Thema. Den öffentlichen Auftakt zum DSI Desinformation Month macht ein Vortrag von Edda Humprecht von der Universität Jena zum Thema, wie digitale Entwicklungen und Desinformation die öffentliche Meinung weltweit beeinflussen. Sacha Altay wird am 30. Oktober zusammen mit Emma Hoes sprechen. Der Titel seines Vortrags: «Everything You Know About Disinformation is Wrong»