Navigation auf uzh.ch

Navigation auf uzh.ch

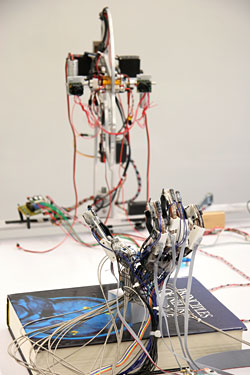

Das Roboter-Kleinkind «iCub» macht prächtige Fortschritte. Bereits kann es mit seinem Vision System einem Gegenstand nachschauen, dazu den Kopf drehen und neigen, den linken Arm gezielt nach einem Objekt ausstrecken und diesen mit einer provisorischen Hand greifen – um nur ein paar seiner sensomotorischen Fähigkeiten aufzuzählen. – Tönt zwar simpel, ist aber alles andere als einfach, wie einer seiner zahlreichen «Väter», Professor Rolf Pfeifer vom Artificial Intelligence Lab der Universität Zürich, betont.

Ziel des im Mai 2004 gestarteten EU-Forschungsprojekts RobotCub ist es, innerhalb von fünf Jahren einen Roboter zu bauen, der die sensomotorischen Fähigkeiten eines Zweijährigen aufweist; will heissen: der greifen, krabbeln, sich hinsetzen, Bewegungen koordinieren und vielleicht sogar aufstehen kann. Vor vierzehn Tagen trafen die zehn europäischen RobotCub-Teams in Genua zusammen, um sich über die neusten Fortschritte des «Kleinen» auszutauschen. Forscher wie Geldgeber waren sehr zufrieden, berichtet der Physiker und Roboter-Experte Rolf Pfeifer.

Zwei Jahre arbeiten die interdisziplinären Teams mittlerweile an iCub. In dieser Zeit haben sie es geschafft, wirklich voneinander zu lernen, erzählt Pfeifer. Mittlerweile sei es nicht mehr einfach so, dass die Informatiker und Ingenieure von den Kenntnissen der Entwicklungspsychologen und Neurowissenschaftlern (die ihnen eine Road Map lieferten, wie sich Babys in den ersten zwei Jahren entwickeln) einseitig profitierten. Mittlerweile lernen auch die Entwicklungspsychologen (wie der Schwede Claes von Hofsten von der University of Uppsala) von den ganz anderen Fragestellungen der Techniker. Weil Ingenieure ja letzten Endes etwas bauen müssen, ist für sie die Physis, die Gestalt, das Material enorm wichtig – davon haben sich die Leute um den Humanphysiologen und Mitentdecker der Spiegelneuronen, Luciano Fadiga von der italienischen Universität Ferrara, inspirieren lassen, und sie planen für später ein Imitationsexperiment, bei dem der Blickkontakt von Menschen und Robotern untersucht werden soll. «Die interdisziplinäre Arbeit trägt Früchte», ist Pfeifer zufrieden.

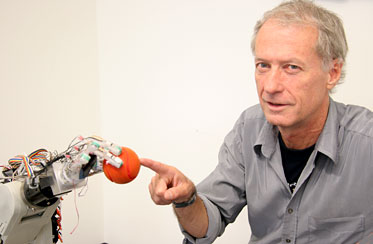

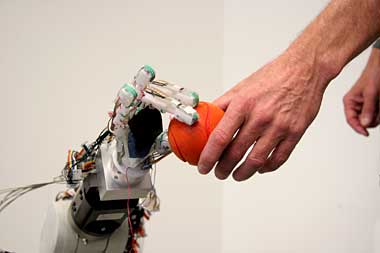

Das Artificial Intelligence Lab der Universität Zürich ist für die Bewegungen der Hand und deren Koordination mit dem Sehapparat von Roboter-Baby «iCub» zuständig.

«Object tracking» nennen Techniker den Reflex eines Kleinkindes, einem sich bewegenden Objekt nachzuschauen – indem es die Augen bewegt und, falls nötig, den Kopf dreht. «Isoliert betrachtet, eine relativ einfache Angelegenheit», sagt Pfeifer, dessen Team zusammen mit den Neurobiologen der Universität Ferrara und anderen Gruppen am Problem arbeitet. Will das Kind oder der Roboter nach dem Objekt, beispielsweise einem Ball, auch noch greifen, wird die Aufgabe schwieriger – gilt es doch, Sehsystem und Muskeln zu koordinieren und eine Fülle von Unteraufgaben miteinander zu kombinieren: Ball anschauen, um anhand seiner Oberfläche abzuschätzen, wie schwer er ist, den Arm nicht zu weit und nicht zu wenig ausstrecken und die Finger so auf dem Ball positionieren, dass dieser nicht herunterfällt, aber auch nicht gequetscht wird – eine grosse Koordinationsleistung zwischen Hirn/Programmierung, Muskeln/Motoren und Sehnerven/Vision System.

Sehr hilfreich bei solchen sensomotorischen Aktivitäten ist das zweite Fachgebiet des Zürcher Teams, das Lernenlassen.

«Wir programmieren nicht einfach fix, wie iCub's Hand nach einem Objekt greift und die Augen dabei schauen, sondern wir lassen den Roboter die Hand-Augen-Koordination lernen», erklärt Pfeifer. Dadurch muss bei kleinen Abweichungen der Hand- oder Kopfposition nicht der ganze Ablauf neu programmiert werden, sondern der Computer lernt selbst mit Variationen umzugehen – beispielsweise wenn iCub dereinst «wachsen» sollte und sich dadurch sämtliche Positionen und Winkelrelationen von Auge, Arm und Hand ändern, oder wenn der Ball aus einem schwereren Material ist und den Kleinen umzukippen droht.

Als erwünschten Nebeneffekt des Ziels, iCub lernen zu lassen, gewinnt das Zürcher Team allgemeine Erkenntnisse, wie Lernmechanismen funktionieren. Auf der Hypothese des russischen Physiologen Nicolas Bernstein aufbauend, konnte es anhand von Roboterexperimenten zeigen, dass Lernen effizienter ist, wenn nicht gleich von Beginn an sämtliche Freiheitsgrade verwendet, sondern gewisse anfänglich «eingefroren» werden, und erst später, wenn der Roboter die Grundbewegungen gelernt hat, hinzugenommen werden.

Erwachsene wissen in den allermeisten Fällen bereits wenn sie einen Gegenstand anschauen, wie stark sie die Hand öffnen und wie viel Kraft ihre Finger aufwenden müssen, beispielsweise um die Kaffeetasse an den Mund zu führen – ihre sensomotorischen, visuellen und taktilen Fähigkeiten spielen perfekt zusammen. «Die isolierten Fähigkeiten Sehen, Bewegen und Greifen zusammenzubringen, das ist die grosse Herausforderung», erklärt Pfeifer. Auch iCubs neuronales Netz soll solch crossmodales Lernen bewältigen können.

Da Kleinkinder sich das meiste durch Nachahmung aneignen, soll iCub ausserdem durch Imitation weiterkommen; mit dem Imitationslernen beschäftigen sich die Teams von London, Ferrara und der ETH Lausanne.

Die Art des Materials, aus dem ein Roboter gebaut ist, bestimmt zu einem wesentlichen Teil seine Fähigkeiten und die Probleme, die er mit Bewegungen hat. Menschliche Muskeln sind unter anderem elastisch, im Gegensatz zu iCubs metallenen Gelenken und miniaturisierten Motoren. Das Roboter-Baby besteht zur Hauptsache aus harten Materialien – entsprechend aufwendig sind ihm alle federnden, elastischen Bewegungen beizubringen – wie beispielweise das Greifen schwerer Gegenstände, bei dem der menschliche Arm wippend ausgleichen kann, oder das Gehen, bei dem das Bein «von alleine» nachschwingt. «Ich hoffe sehr, dass in einem Folgeprojekt mit anthropomorphen Materialen gearbeitet wird», sagt Pfeifer, «sie erlauben ein menschenähnlicheres Fortbewegungs-Design.» Pfeifer wäre am liebsten schon beim europäischen RobotCub-Projekt «eine Spur fortschrittlicher» vorgegangen, doch wollte die EU auf sicheren Werten aufbauen und nicht mit wenig erprobten Material-Technologien experimentieren.

Doch auch mit den konventionellen Roboter-Materialien und -Technologien wird iCub seinen Wissenschaftsvätern eine Menge beigebracht haben, wenn er dereinst auf einen hüpfenden Ball loskrabbelt, aufsitzt und nach dem runden Ding greift – so als wäre das ganz einfach.